História da Informática

Informática é o ramo do conhecimento dedicado ao tratamento de informação, através de computadores. Sua abrangência é fluida e vem se adaptando às revoluções da área.

Os primórdios da Informática mescla-se com o desenvolvimento da matemática e a evolução das comunicações. O ábaco foi a primeira tecnologia de cálculo conhecida. Iniciou-se com a contagem de pedrinhas e aperfeiçoou-se no Oriente. Até o final do século 20, o soroban, o ábaco japonês, e o milenar suanpan, o ábaco chinês, ainda eram ensinados nas escolas desses países.

No início do século 17, o clérigo inglês William Oughtred criou a primeira régua de cálculo, que se tornou um equipamento indispensável a engenheiros até a popularização das calculadoras eletrônicas, no final dos anos 1970. Em 1642, Blaise Pascal inventou o pascaline: a primeira calculadora mecânica, que pode ser entendida como o primeiro computador analógico. Em 1673, o matemático alemão Leibniz construiu uma máquina de calcular mecânica com base na calculadora de Pascal, mas incluindo multiplicação.

Em 1822, o matemático inglês Charles Babbage projetou um computador mecânico, utilizando o método das diferenças, mas não o construiu. Somente em 2002, em Londres, seu mecanismo foi finalmente construído de acordo com o projeto original. O Difference Engine Nº 2 consiste de oito mil peças, pesa cinco toneladas e tem 3,3 metros de comprimento.

Em meados do século 19, o matemático inglês George Boole desenvolveu um sistema algébrico com base em operações de lógica matemática. Esse sistema é a base das operações computacionais atuais, em destaque, operações binárias.

Em 1880, o norte-americano Herman Hollerith criou um processador de dados eletromecânico, utilizando cartões perfurados para inserir dados. Em 1930, o engenheiro Vannevar Bush desenvolveu um computador com válvulas.

Durante a Segunda Guerra Mundial muitos cientistas foram envolvidos no desenvolvimento de computadores para auxiliar esforços de guerra. Na Alemanha foi criada a Enigma, uma máquina de criptografia eletromecânica para a transmissão de mensagens secretas. Na Grã-Bretanha, uma equipe integrada pelo matemático Alan Turing conseguiu decifrar códigos secretos alemães após desenvolver um equipamento computacional. Nos Estados Unidos, computadores analógicos eram parte integrante do Projeto Manhattan, que desenvolveu as bombas atômicas jogadas no Japão.

Nos anos 1940, o rádio tornou-se um meio de transmissão em massa.

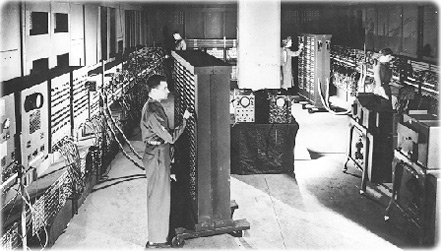

Ainda durante a Guerra, em 1943, começou o desenvolvimento do Eniac (Electronic Numerical Integrator and Computer), o primeiro computador eletrônico digital. O projeto foi liderado pelos engenheiros norte-americanos J. W. Mauchly e J. P. Eckart, na Universidade da Pennsylvania. O Eniac entrou em funcionamento em fevereiro de 1946, era o mais poderoso equipamento de cálculo construído até então e já possuía recursos de programação sofisticados para a época. O Eniac ocupava um espaço de 15m x 9m do porão da Moore School of Electrical Engineering.

Em 1948, o matemático Norbert Wiener (1894-1964), professor do MIT - Instituto de Tecnologia de Massachusetts, lançou o livro Cybernetics, explorando filosoficamente a comunicação e o controle entre animais e máquinas. A partir de 1954, foram escritos os primeiros programas que davam capacidade de aprendizado aos computadores, a Inteligência Artificial começava a ganhar raízes no mundo real. Em 1956, o MIT também desenvolveu o primeiro computador com base em transistores.

No final dos anos 1950, a televisão tornou-se um meio de transmissão em massa. Em 1967, começaram as transmissões internacionais de TV, ao vivo, via satélite. Em 1969, homens pisaram na Lua.

No início do anos 1970, circuitos integrados tomaram o lugar dos transistores individuais. A Intel lançou os primeiros processadores que permitiram o desenvolvimento de microcomputadores. Ainda nos anos 1970, começou a ser formada uma rede mundial de computadores, que se tornaria a Internet.

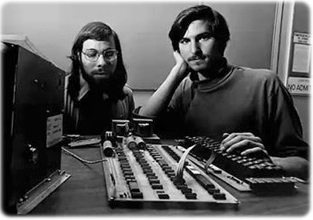

Em 1977, Steve Wozniak e Steve Jobs, que fundaram a Apple no ano anterior, lançaram o Apple II, o primeiro microcomputador mundialmente popular. Em 1981, a IBM lançou o personal computer (PC) com sistema operacional fornecido pela Microsoft: o DOS. O PC estabeleceu padrões para os futuros microcomputadores. Em 1983, a Apple lançou o Lisa, um sistema operacional com interface gráfica, cujas bases foram desenvolvidas no Xerox Palo Alto Research Center, na California. Os executivos da Xerox, sem entender bem o que seus engenheiros desenvolveram, cederam a maravilha gratuitamente para a Apple. Em 1984, a Apple lançou o Macintosh, o computador que popularizou a interface gráfica. Foi um sucesso de marketing, mas não comercial. Em 1985, Steve Jobs brigou com os executivos da Apple e saiu da Empresa. Nos anos seguintes, a Apple passou a perder espaço para a Microsoft e a plataforma PC.

Entusiasmados com as possibilidades dos microcomputadores, Bill Gates e Paul Allen fundaram a Microsoft, em 1975. Em 1981, forneceu o sistema operacional para o PC da IBM, que se tornou a principal plataforma de microcomputadores nas décadas seguintes. Diferente da Apple, a Microsoft não fabricava o hardware que rodava seu sistema operacional, o DOS. Assim, surgiram muitas empresas que fabricavam o hardware e licenciavam o DOS. Essa foi a base que sustentou o boom dos PCs nos anos 1990.

Seguindo a estrada pavimentada pela Apple, a Microsoft lançou a primeira versão do Windows, em 1985, mas sem sucesso. O maior problema na época era a capacidade de processamento dos microcomputadores. Já existiam estações gráficas, com base em processadores unix, lançadas, por exemplo, pela Sun Microsystems e pela Silicon Graphics. Eram usadas principalmente para processamento de imagens, mas custavam fortunas.

Em 1991, Linus Torvald lançou a primeira versão do sistema operacional Linux com código aberto. Softwares livres tornaram-se uma tendência, em vários setores, invadiram empresas e serviços públicos.

Em 1986, a NSF (U.S. National Science Foundation) iniciou o desenvolvimento dos primeiros backbones da Internet. Em 1989, o físico Tim Berners-Lee propôs um modelo de hipertexto, que viria a ser conhecido como a World Wide Web. Berners-Lee escreveu o código do primeiro servidor WWW e o primeiro editor de hipertexto. Em 1991, seu trabalho foi disponibilizado para a Internet. Em 1994, Berners-Lee fundou a World Wide Web Consortium (W3C). Em 1995, o termo Internet tornou-se oficial e surgiram os primeiros provedores para o público comum, contratados pela NSF. Estabeleceram-se os princípios comerciais para a concessão de domínios. No Brasil, os primeiros provedores comerciais surgiram no final do ano, quando a Embratel liberou o acesso.

A partir de 1992, a interação com o PC tornou-se irresistível. Os PCs começaram a se popularizar, alavancados pelo lançamento do Windows 3.1, de 16 bits, com processadores 80386, da Intel. Mas o ponto de inflexão foi 1995, com o lançamento do Windows 95, de 32 bits, em PCs com processadores Pentium da Intel. Nos anos seguintes, os fabricantes de mainframes, como a IBM (que havia lançado o PC), passaram a perder espaço nas empresas. Os datilógrafos também. Os PCs já vinham com os principais aplicativos para as empresas, como planilhas, gerenciadores de bancos de dados, processadores de textos e de imagens. O Microsoft Office vinha com todos eles e coisas mais, tornou-se o principal ganha-pão da Empresa e padrão de mercado. Redes de microcomputadores passaram a disputar espaço com o sistema mainframe/terminais de vídeo.

Mas os mainframes ganharam maior poder de processamento e continuaram no mercado, principalmente para o processamento de grandes bancos de dados, caso, por exemplo, de Meteorologia e de sistemas financeiros. Em 1979, a Oracle lançou comercialmente o primeiro Sistema Gerenciador de Banco de Dados Relacional. Conceitos e técnicas de mineração de dados estavam amadurecendo. Em 1996, para divulgar seu poder de processamento, a IBM lançou um desafio entre o campeão mundial de xadrez Garry Kasparov e o Deep Blue, seu supercomputador. O Deep Blue perdeu, mas a IBM não desistiu e novo confronto foi realizado no ano seguinte, com vitória do Deep Blue.

Na segunda metade dos anos 1990, tecnologias que requeriam elevado poder de processamento gráfico começaram a se popularizar. Nas residências, os joguinhos ganharam novas dimensões. Nas empresas, as aplicações eram inúmeras, em especial, os sistemas de informações geográficas (GIS), integrados com o Global Positioning System (GPS), revolucionavam as formas de obter e analisar dados espaciais.

Em 1997, os microcomputadores da Apple haviam se tornado quase uma curiosidade, embora ainda usados por algumas empresas em editoração eletrônica (termo da época). Desesperados, seus executivos chamaram de volta Steve Jobs, que deu novo alento à Empresa com sua criatividade.

Mas no final dos anos 1990, as grande estrelas no mundo da tecnologia eram a Microsoft e a Intel. O Internet Explorer suplantou o Nestscape Navigator e tornou-se o navegador mais popular, o AltaVista era o principal mecanismo de busca e o Yahoo!, o maior portal da Internet. Naqueles anos visualizava-se um novo mundo, muitas empresas foram fundadas buscando novos mercados, boa parte sem pé nem cabeça, mas com corpos robustos em ações, que atingiram os céus em movimentos especulativos. Os valores das empresas de tecnologia foram denunciados como "exuberância irracional" por Alan Greenspan, então, Chairman do Federal Reserve.

Em maio de 1998, o Departamento de Justiça dos EUA abriu um processo antitrust contra a Microsoft. Ao que parece, Bill Gates percebeu que suas aspirações envolvendo sua Empresa seriam sempre limitadas pela justiça. Seu momentum foi freado. Desestimulado, em julho do mesmo ano, ele cedeu o cargo de presidente da Microsoft para Steve Ballmer. Em novembro de 1999, a Corte Federal de Justiça declarou que a Microsoft tinha monopólio na plataforma PC e medidas deveriam ser tomadas para quebrar tal monopólio. Em 2000, Gates e sua esposa lançaram sua Fundação e ele passou a dedicar-se à filantropia em boa parte de seu tempo.

Em março de 2000, a "bolha da Internet" estourou. Nos anos seguintes, as empresas sofreram com o freio de arrumação. Restaram parte das empresas de tecnologia que tinham pé e cabeça. A Internet foi se transformando e, além da Amazon, poucos dos protagonistas pioneiros sobreviveram. Surgiram a Wikipédia e o Facebook (2004).

O Yahoo! tinha um popular diretório de web sites e contratou o Google (fundado em 1998) como mecanismo de busca do portal. A parceria Yahoo! - Google durou até que aquele diretório tornou-se obsoleto e o Google ascendeu como nova estrela da Internet. Então o Yahoo! comprou algumas empresas que possuíam tecnologias de busca, incluindo o AltaVista, tentando montar seu próprio buscador, mas fracassou. A Microsoft também adquiriu empresas com tecnologias de busca, mas só conseguiu lançar o Bing. O Google tornou-se o mecanismo de busca dominante e a publicidade online atingiu novos patamares. Em 2008, o Google lançou o navegador Chrome, que não demorou para bater o Internet Explorer.

Em 2007, Steve Jobs lançou o iPhone e o celular ganhou mais razões para ser carregado para todo lugar.

Em 2016, o AlphaGo, um programa de Inteligência Artificial desenvolvido pelo Google para jogar o Go, um jogo de tabuleiro oriental, conseguiu derrotar o sul-coreano Lee Sedol, 18 vezes campeão mundial.

Hoje, a Internet tornou-se tão essencial quanto a energia elétrica. Lidar com o excesso de informações é um desafio para os humanos, mas não para as máquinas, que ficam mais poderosas a cada nano segundo. Processos são cada vez mais executados por computadores e é difícil saber como o mundo será daqui a poucas décadas.

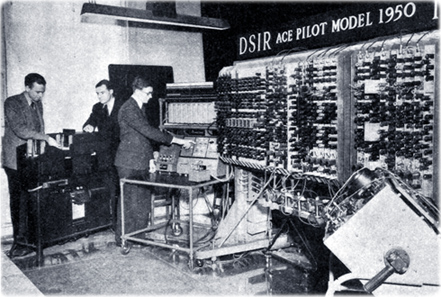

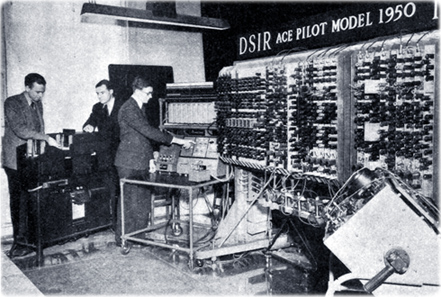

O Automatic Computing Engine, Pilot Model 1950, em exposição no National Physical Laboratory em Teddington, Londres. Esse computador foi projetado por Alan Turing antes dele deixar a Instituição, em 1947.

O Eniac, o primeiro computador digital, em 1946, ocupava uma grande sala. A fantástica realização da época tem várias vezes menor poder de processamento que um telefone celular atual.

|

Copyright © Guia Geográfico - História. |

O computador HAL, que controla a nave mãe, tenta impedir a reentrada do astronauta Dave. Cena de 2001 - Uma Odisseia no Espaço (1968), um dos mais celebrados filmes de ficção científica da história do cinema. HAL assassina os tripulantes da nave, acreditando que ameaçavam a missão para a qual fora programado. O filme de Stanley Kubrick, baseado no livro de Arthur Clarke, aborda possíveis conflitos futuros entre máquinas e humanos. As perigosas relações entre pessoas e futuros computadores artificialmente inteligentes são um tema recorrente na ciência e na ficção, sempre inconclusivos.

Por muitos anos, Stanley Kubrick (1928-1999) tentou desenvolver o tema em um segundo filme, mas não se satisfazia que os possíveis finais deslumbrados. Expôs seus dilemas ao amigo Steven Spielberg. Tinham um projeto em comum adaptado de um texto de Brian Aldiss, de 1969. Após a morte de Kubrick, Spielberg homenageou seu amigo com A.I. - Inteligência Artificial (2001).

Até os anos '80, alguns diziam que era só desligar a tomada, mais ou menos como HAL foi desligado por Dave. Hoje, sabemos o quanto ingênua é essa abordagem.

Do ponto de vista do processamento de informações, atualmente, o que melhor separa máquinas de humanos são os sentimentos. Não tardará muito até que se comece a simulá-los em computadores. Tentarão as ONGs defender os direitos das máquinas?

Computadores já sabem blefar, em partidas de pôker, não tardará para que dominem o teatro, como fazem os políticos.

Os humanos irão se equipar gradativamente com equipamentos e enxertos computacionais, que aumentem seus recursos, mas é inevitável que surjam sistemas inteligentes independentes, cada vez mais complexos.

Qualquer tentativa de se imaginar o que virá parecerá ingênua no futuro. Não devemos esquecer que a ética é uma questão humana e que as máquinas podem ter suas próprias razões.

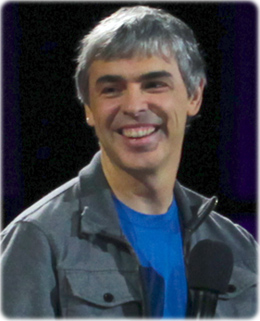

Larry Page, um dos gênios que definem os caminhos tecnológicos do século 21, atual CEO da Alphabet, uma holding que envolve o Google. Lawrence E. Page nasceu em 26 de março de 1973, em Ann Arbor, Michigan, EUA. Em 1998, fundou o Google junto com Sergey Brin, enquanto fazia doutorado na Universidade de Stanford.

Steve Jobs (1955-2011, à direita) e Steve Wozniak, em 1976, ano em que fundaram a Apple. Steven Paul Jobs nasceu em 24 de fevereiro de 1955, em San Francisco, California. Foi um gênio visionário, famoso por saber o que as pessoas queriam antes que elas próprias soubessem. Irascível e incompreendido, Jobs foi demitido de sua própria empresa pelos investidores, em 1985, mas retornou doze anos depois para salvá-la. Jobs trabalhava por pura paixão. Seu salário anual na Apple era de apenas 1 dólar por ano.

História da Informática

Por Jonildo Bacelar

Steve Jurvetson